En el corazón de la arquitectura de microservicios se encuentra el concepto de dividir las aplicaciones en componentes más pequeños e independientes. Cada microservicio se encarga de una funcionalidad específica y opera de manera autónoma. Estos servicios son pequeñas aplicaciones en sí mismas y pueden ser desarrolladas, desplegadas, operadas y escaladas de manera independiente.

El enfoque de microservicios puede proporcionar numerosos beneficios a las organizaciones de desarrollo de software y es especialmente eficaz en escenarios donde los requerimientos del negocio son muy dinámicos y evolucionan con rapidez. Sin embargo, también trae consigo sus propios retos.

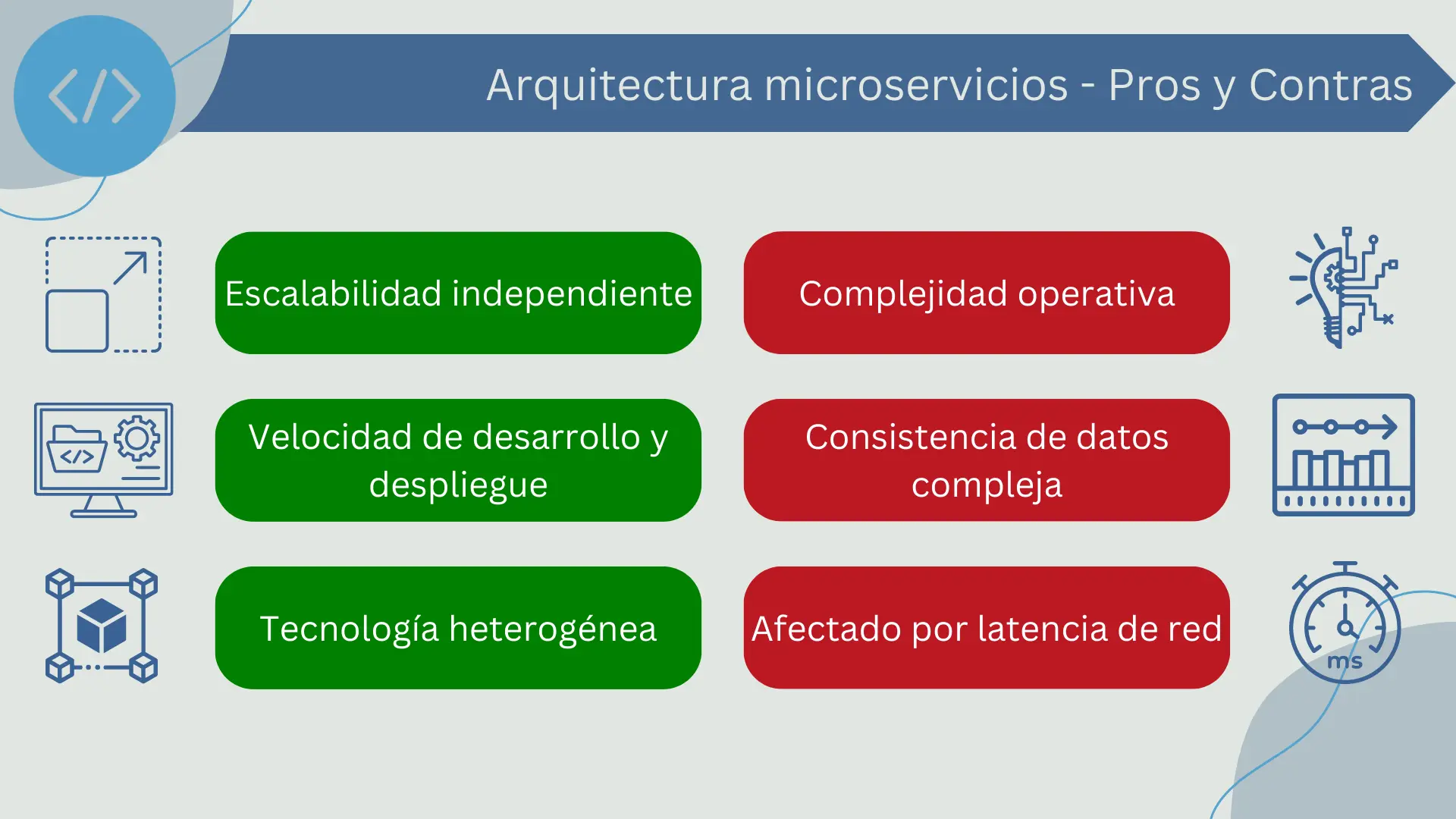

Algunas ventajas del uso de microservicios son:

- Escalabilidad independiente: Cada servicio puede escalar independientemente en función de su demanda específica. Esto puede llevar a un uso más eficiente de los recursos y a una mejor capacidad para manejar picos de carga.

- Velocidad de desarrollo y despliegue: Como los servicios son independientes entre sí, los equipos pueden desarrollar, probar y desplegar cada servicio de forma independiente y en paralelo. Esto puede conducir a una mayor velocidad de desarrollo y despliegue.

- Tecnología heterogénea: Cada microservicio puede ser desarrollado utilizando la tecnología más adecuada para su funcionalidad específica. Esto significa que podrías tener un microservicio escrito en Java, otro en Python, y otro en Node.js, todos trabajando juntos en la misma aplicación.

A pesar de estas ventajas, existen algunas desventajas que se deben considerar a la hora de optar por este tipo de arquitectura:

- Complejidad operativa: Gestionar numerosos servicios independientes puede ser complejo. Necesitas herramientas y procesos para manejar el despliegue, el monitoreo, la comunicación entre servicios, el manejo de errores y la escalabilidad de cada servicio individual.

- Consistencia de datos: Mantener la consistencia de los datos a través de múltiples servicios puede ser un reto, ya que cada microservicio tiene su propia base de datos.

- Latencia de la red: Como los microservicios a menudo se comunican entre sí a través de la red, la latencia puede ser un problema. Las solicitudes que requieren comunicación entre varios servicios pueden ser más lentas que en una arquitectura monolítica.

Estructura de microservicios

La arquitectura de microservicios divide una aplicación en una colección de servicios más pequeños e independientes que están organizados en torno a funcionalidades específicas del negocio. Cada uno de estos servicios puede ser desarrollado, desplegado y escalado de forma independiente, lo que proporciona una gran flexibilidad en la gestión de la aplicación.

- Bases de código: Cada microservicio tiene su propia base de código, que puede ser escrita en cualquier lenguaje de programación que sea más adecuado para la funcionalidad específica del servicio. Esto significa que diferentes microservicios dentro de la misma aplicación pueden estar escritos en diferentes lenguajes.

- Base de datos: Cada microservicio tiene su propia base de datos, lo que permite que cada servicio gestione su propio modelo de datos. Esto aísla a los servicios entre sí, asegurando que un problema en un servicio no afecte a los demás. Sin embargo, esta segregación también puede complicar las operaciones que requieren transacciones o consultas a través de múltiples servicios.

- Comunicación entre Servicios: Los microservicios se comunican entre sí mediante protocolos de red ligeros, típicamente HTTP/REST o gRPC, y utilizan formatos de intercambio de datos como JSON o Protocol Buffers. Las peticiones de los clientes generalmente llegan a través de una interfaz de API, que luego enruta las peticiones a los servicios correspondientes. La comunicación entre microservicios puede ser sincrónica o asíncrona. En la comunicación sincrónica, un servicio espera una respuesta de otro servicio antes de continuar. En la comunicación asíncrona, un servicio envía un mensaje a otro servicio y luego continúa su procesamiento sin esperar una respuesta.

- Servicio de Descubrimiento: En una arquitectura de microservicios, puede haber decenas o incluso cientos de servicios diferentes. Para gestionar esta complejidad, muchos sistemas de microservicios utilizan un servicio de descubrimiento que permite a los servicios encontrar y comunicarse entre sí. El servicio de descubrimiento mantiene un registro en tiempo real de todos los servicios en el sistema y su estado actual.

Base de código

Cada microservicio en una arquitectura de microservicios es independiente y encapsula una funcionalidad específica. Esta independencia se extiende a la base de código de cada servicio.

La base de código de un microservicio es el conjunto de código fuente que define su funcionalidad. En arquitecturas de microservicios, cada servicio tiene su propia base de código separada. Esto significa que cada microservicio puede ser desarrollado, probado y desplegado de forma independiente de los demás. Esta independencia puede conducir a una mayor productividad y eficiencia, ya que los equipos de desarrollo pueden trabajar en paralelo y hacer cambios en sus respectivos servicios sin afectar a los demás.

Además, cada microservicio puede ser desarrollado utilizando el lenguaje de programación que sea más adecuado para su funcionalidad específica. Esto significa que no estás limitado a un solo lenguaje de programación para toda la aplicación. Por ejemplo, podrías tener un microservicio para procesamiento de imágenes que esté escrito en Python (que tiene excelentes bibliotecas para el procesamiento de imágenes), mientras que otro servicio que maneje la lógica de negocio podría estar escrito en Java o C#.

Sin embargo, esta diversidad también puede tener sus desafíos. Puede ser más difícil gestionar un proyecto con múltiples lenguajes de programación, y los equipos de desarrollo deben estar equipados con una amplia gama de habilidades para poder mantener y mejorar cada servicio. Por lo tanto, a pesar de la flexibilidad que esta independencia puede proporcionar, es crucial mantener ciertos estándares y prácticas de codificación coherentes en todos los servicios para asegurar la mantenibilidad y la coherencia del código.

Bases de datos

En una arquitectura de microservicios, cada servicio tiene su propia base de datos independiente. Esto se conoce como el principio de la base de datos por servicio. Este enfoque ayuda a asegurar que cada servicio es lo más desacoplado posible de los demás, lo que a su vez facilita el desarrollo, despliegue y escalado independientes de cada servicio.

Tener bases de datos separadas para cada microservicio tiene varias ventajas. La primera es que reduce el acoplamiento entre los servicios. Si un servicio falla o se cae, los datos de los demás servicios no se ven afectados. En segundo lugar, cada servicio puede utilizar el tipo de base de datos que mejor se adapte a sus necesidades. Por ejemplo, un servicio que maneja relaciones complejas entre entidades podría utilizar una base de datos relacional, mientras que otro servicio que maneja grandes volúmenes de datos de series temporales podría utilizar una base de datos NoSQL optimizada para ese propósito.

Sin embargo, este enfoque también tiene sus desafíos. El primero es gestionar la consistencia entre servicios. Como cada microservicio tiene su propia base de datos, mantener la consistencia entre diferentes servicios puede ser complicado, especialmente en operaciones que abarcan múltiples servicios.

Además, realizar consultas a través de múltiples servicios puede ser más complejo que en una arquitectura monolítica. En una aplicación monolítica, podrías hacer una única consulta a la base de datos para obtener todos los datos que necesitas. Pero en una arquitectura de microservicios, estos datos pueden estar dispersos en múltiples bases de datos, y es posible que necesites hacer múltiples llamadas a diferentes servicios para reunir todos los datos que necesitas.

Por último, este enfoque puede aumentar la complejidad de las operaciones de base de datos. Necesitarás herramientas y procesos para gestionar múltiples bases de datos, cada una posiblemente utilizando diferentes tecnologías. Además, las operaciones de backup y restauración pueden ser más complejas y es posible que necesites coordinar estas operaciones a través de todos tus servicios.

Comunicación entre servicios

La comunicación entre servicios es fundamental en una arquitectura basada en microservicios. Como los microservicios son autónomos y se encargan de diferentes funcionalidades, necesitan interactuar entre sí para completar las operaciones de la aplicación.

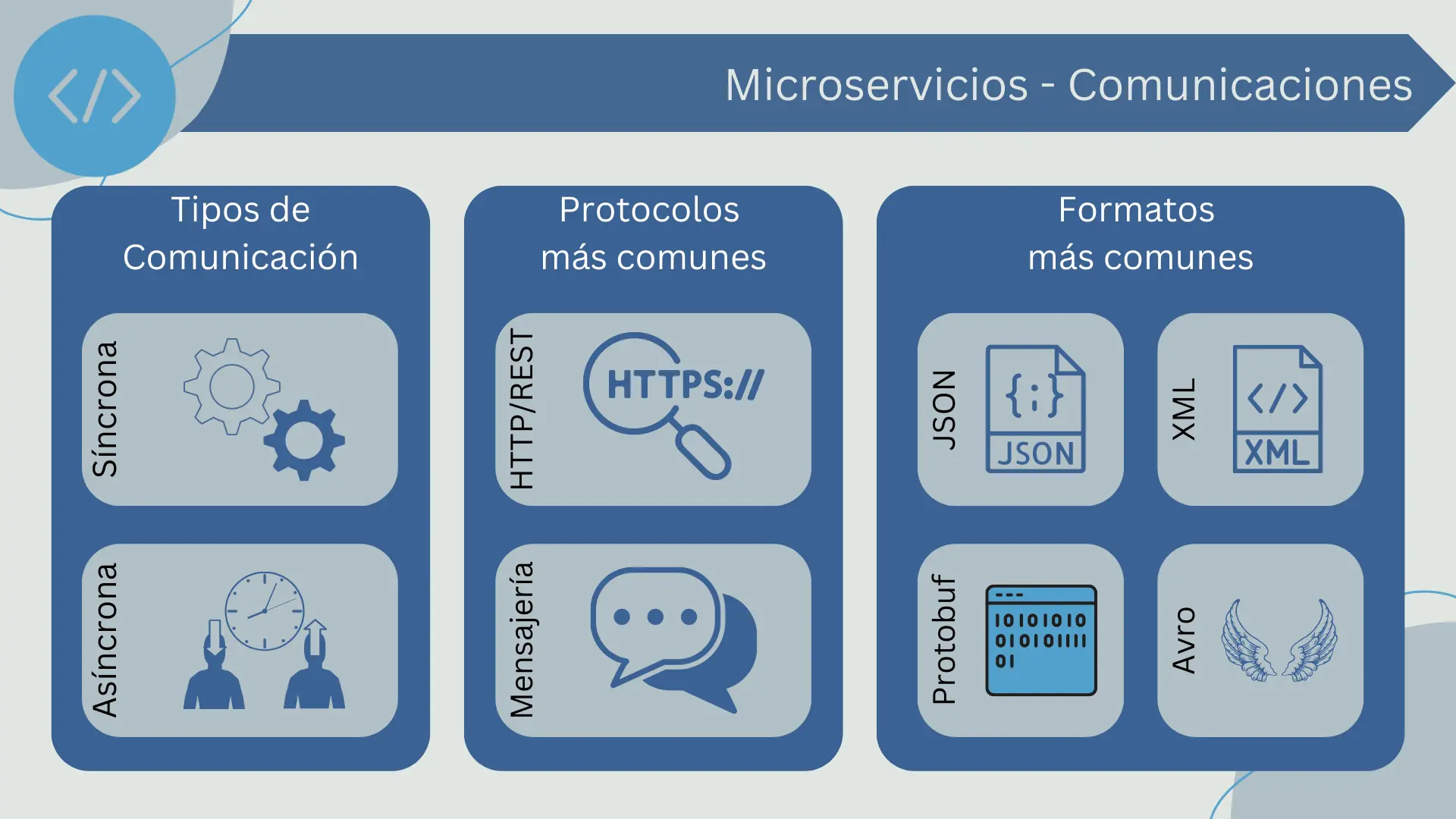

Las formas más comunes de comunicación entre microservicios son las peticiones HTTP/REST y el uso de protocolos de Mensajería, aunque también se pueden utilizar otras técnicas como gRPC o GraphQL.

- HTTP/REST: es una forma común de comunicación entre microservicios debido a su simplicidad y universalidad. En este modelo, un microservicio realiza una petición HTTP a otro microservicio, que responde con los datos solicitados o con una confirmación de que la acción solicitada se ha realizado.

- Mensajería: El uso de un sistema de mensajería es otra forma común de comunicación entre microservicios. En este caso, los microservicios publican y consumen mensajes de un bus de mensajería, que puede ser un sistema de colas de mensajes, un sistema de streaming de datos o similar. Esto permite la comunicación asíncrona y puede ayudar a desacoplar aún más los microservicios.

La comunicación entre microservicios puede ser sincróna o asíncrona. En la comunicación sincrónica, un servicio espera una respuesta de otro servicio antes de continuar. En la comunicación asíncrona, un servicio envía un mensaje a otro servicio y luego continúa su procesamiento sin esperar una respuesta. Ambas tienen sus pros y sus contras, y la elección depende de las necesidades específicas de la aplicación.

También es necesario en este punto mencionar el formato de los datos, que define cómo se estructura la información que se envía entre los servicios. Los dos formatos más comunes utilizados en las arquitecturas de microservicios son JSON y XML, aunque otros formatos como Protocol Buffers o Avro también se pueden utilizar dependiendo de las necesidades específicas del sistema.

- JSON (JavaScript Object Notation): es un formato de datos ligero y fácil de leer para humanos y máquinas. Es ampliamente utilizado en aplicaciones web y es el formato de datos por defecto para muchas APIs RESTful. JSON es particularmente útil en una arquitectura de microservicios debido a su simplicidad y versatilidad.

- XML (eXtensible Markup Language): es otro formato de datos comúnmente utilizado en la comunicación entre servicios. Aunque es más verboso que JSON, XML es extremadamente flexible y permite una descripción más detallada de los datos. Esto puede ser beneficioso en sistemas donde los datos son complejos o donde se requiere un alto grado de interoperabilidad.

- Protocol Buffers (también conocidos como Protobuf): son un formato de datos binario desarrollado por Google. Son más eficientes en términos de tamaño y velocidad de procesamiento que JSON o XML, pero son menos legibles para los humanos. Los Protocol Buffers pueden ser una buena opción en sistemas donde el rendimiento es una preocupación importante.

- Avro: es un formato de datos binario que también soporta la definición de esquemas. Fue desarrollado en el contexto del proyecto Apache Hadoop para ser utilizado en sistemas distribuidos de big data. Avro es útil en sistemas donde los datos deben ser persistidos o enviados a través de la red con alta eficiencia.

Es importante recordar que el formato de datos elegido debe ser adecuado para las necesidades específicas de tu sistema. Cada formato tiene sus propias ventajas y desventajas, y la elección entre ellos dependerá de factores como la complejidad de tus datos, las necesidades de rendimiento de tu sistema, y las tecnologías que estés utilizando.

Descubrimiento de servicios

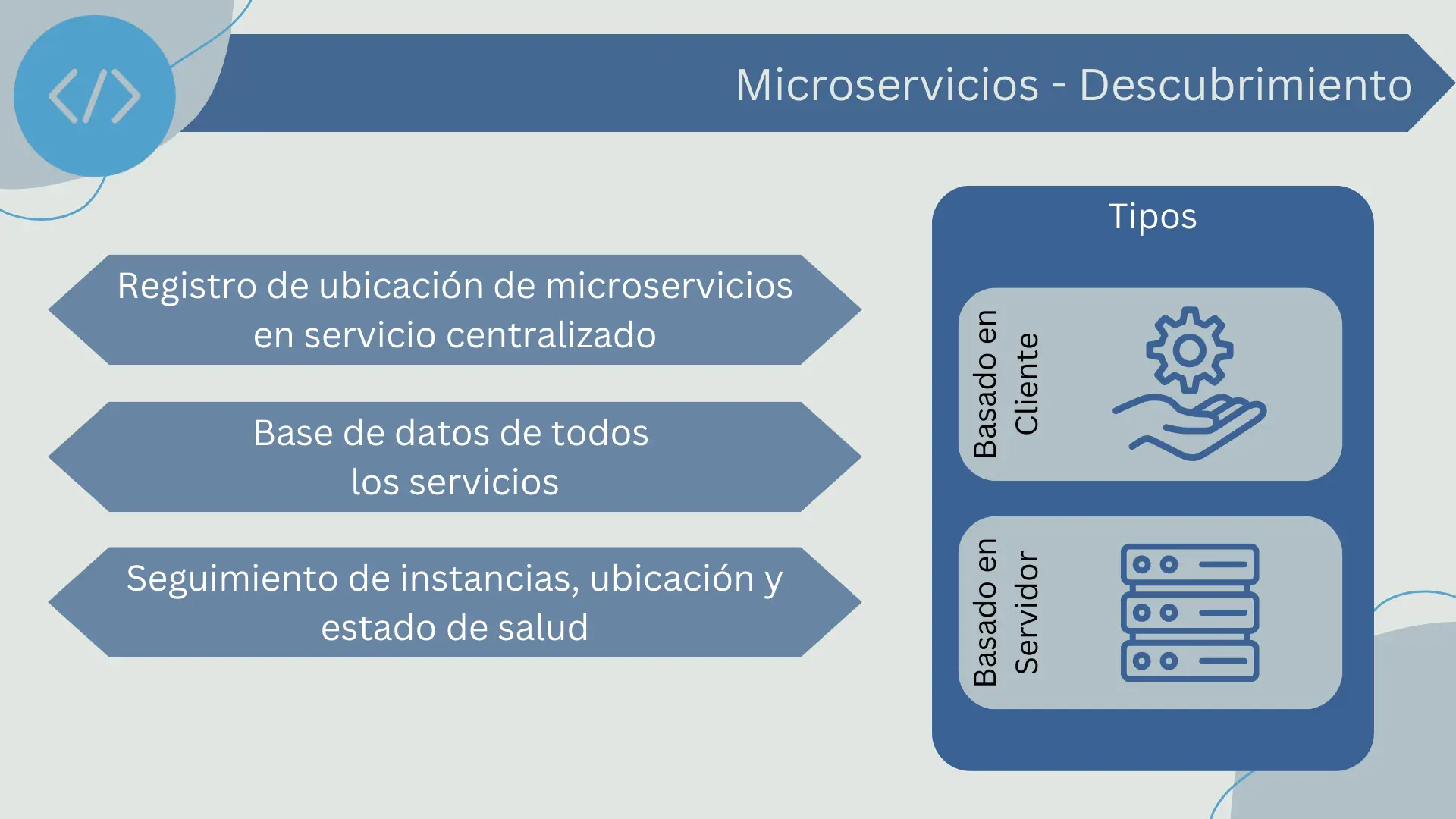

En una arquitectura de microservicios, con frecuencia tenemos una gran cantidad de servicios que necesitan comunicarse entre sí. Sin embargo, debido a la naturaleza dinámica y escalable de esta arquitectura, los servicios pueden cambiar, escalar, y moverse con frecuencia. Es aquí donde el descubrimiento de servicios se vuelve crítico.

El descubrimiento de servicios es un patrón en el que los microservicios pueden registrar su ubicación en un registro de servicios centralizado y también pueden buscar y descubrir otros servicios utilizando este registro.

El registro de servicios actúa como una base de datos o directorio de todos los servicios disponibles en la arquitectura de microservicios, manteniendo un seguimiento de las instancias de servicio, su ubicación y su estado de salud. Cuando un nuevo microservicio se despliega, se registra en este directorio proporcionando toda la información necesaria. Si un servicio se cae o es retirado, también se actualiza en el registro. Si un servicio falla en la comprobación de salud que debe ejecutar regularmente, se marca como no disponible en el registro.

Existen dos enfoques principales para el descubrimiento de servicios: el descubrimiento basado en el cliente y el descubrimiento basado en el servidor.

- En el descubrimiento basado en el cliente, los propios clientes de servicio son responsables de determinar las ubicaciones de los servicios y hacer balanceo de carga. Para hacerlo, consultan el registro de servicios, seleccionan un servicio y luego realizan la solicitud.

- En el descubrimiento basado en el servidor, el cliente hace la solicitud a través de un enrutador, que es un componente intermedio entre el cliente y los servicios. El enrutador consulta al registro de servicios y utiliza el balanceo de carga para redirigir la solicitud al servicio adecuado.

La implementación eficiente del descubrimiento de servicios puede ser un desafío debido a la necesidad de mantener la coherencia del registro, la necesidad de un descubrimiento de servicios rápido y eficiente y la necesidad de manejar fallas y cambios en la disponibilidad del servicio. Sin embargo, su papel es crucial para mantener una arquitectura de microservicios eficiente y flexible.

Manejo de peticiones

El manejo de peticiones en una arquitectura de microservicios es un aspecto crucial que necesita una cuidadosa consideración. Debido a la naturaleza distribuida de los microservicios, una única solicitud del cliente puede implicar varias peticiones entre varios servicios. A continuación, se exploran algunos conceptos importantes relacionados con el manejo de peticiones en los microservicios.

Orquestación y Coreografía

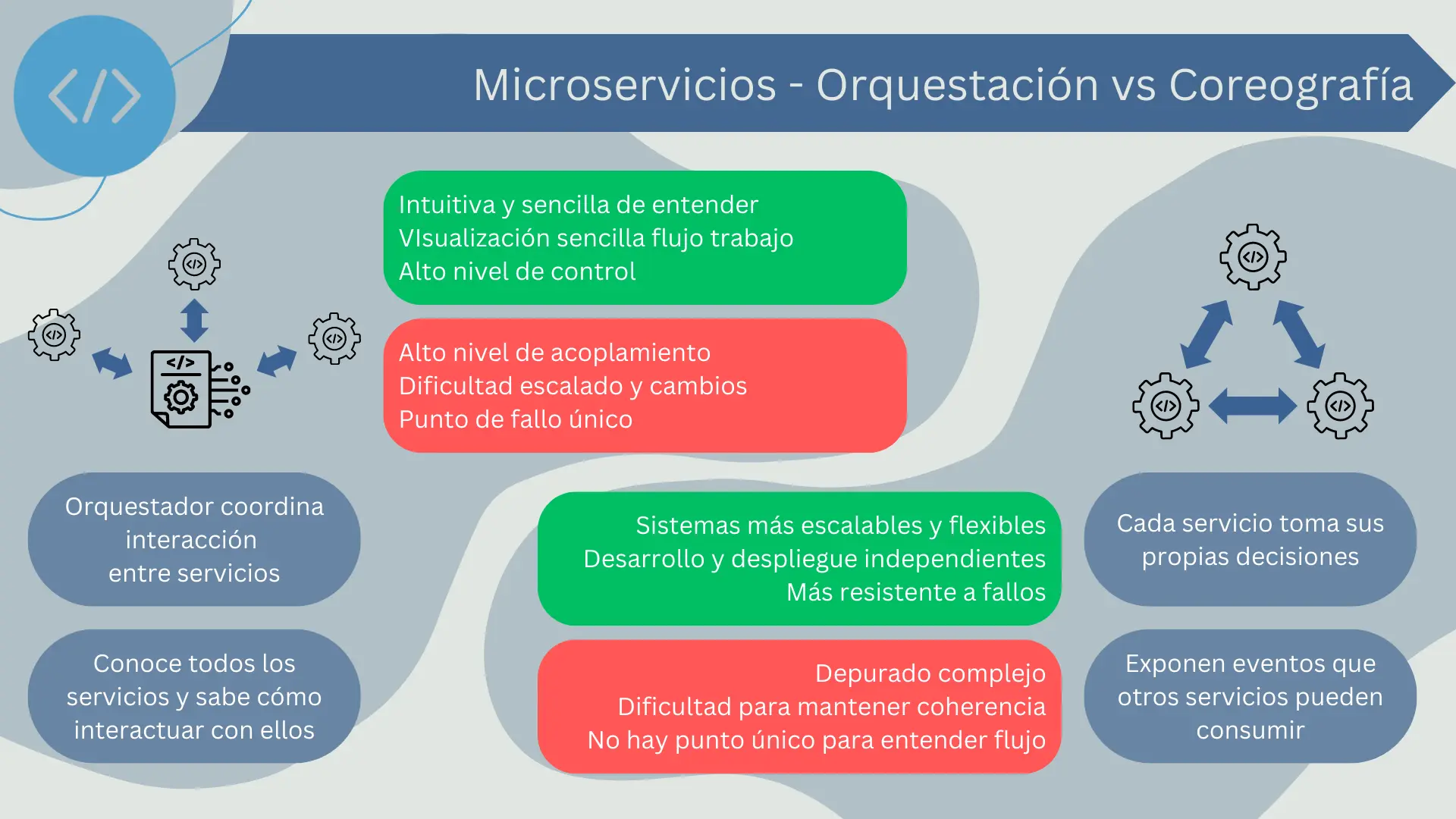

La orquestación y la coreografía son dos enfoques para coordinar las interacciones entre microservicios. Ambos tienen sus propias ventajas y desventajas, y la elección entre uno u otro a menudo depende del problema específico que se está resolviendo.

En la práctica, muchas arquitecturas de microservicios utilizan una combinación de orquestación y coreografía. Algunos flujos de trabajo pueden ser mejor manejados por un orquestador, mientras que otros pueden beneficiarse de la naturaleza más descentralizada de la coreografía. La clave es entender los beneficios y las limitaciones de cada enfoque y aplicar el más adecuado para cada situación.

Orquestación

La orquestación es un patrón en el que un componente, conocido como el orquestador, coordina todas las interacciones entre los servicios. El orquestador es consciente de todos los servicios en la arquitectura y sabe cómo interactuar con cada uno de ellos para cumplir una cierta tarea o flujo de trabajo.

La ventaja de la orquestación es que es bastante intuitiva y sencilla de entender. Los flujos de trabajo pueden ser fácilmente visualizados y razonados porque todo se gestiona desde un único lugar. También permite un alto nivel de control, ya que el orquestador puede manejar las peticiones y las respuestas de manera muy precisa.

Sin embargo, la orquestación puede conducir a sistemas altamente acoplados, ya que el orquestador necesita tener un conocimiento detallado de cada servicio con el que interactúa. Esto puede hacer que el sistema sea más difícil de cambiar y escalar. Además, el orquestador puede convertirse en un punto único de fallo si no se diseña correctamente.

Coreografía

La coreografía es un patrón en el que cada servicio actúa de forma autónoma y toma sus propias decisiones. En lugar de ser dirigidos por un orquestador central, los servicios publican eventos que otros servicios pueden optar por escuchar y reaccionar.

La coreografía puede llevar a sistemas más escalables y flexibles, ya que cada servicio puede ser desarrollado y desplegado independientemente sin necesidad de coordinarse con un orquestador central. También puede hacer que el sistema sea más resistente a los fallos, ya que no hay un único punto de fallo.

Sin embargo, la coreografía puede ser más difícil de entender y razonar, ya que no hay un único lugar para ver toda la lógica del flujo de trabajo. Esto puede hacer que el depurado y la gestión de errores sean más desafiantes. También puede ser más difícil garantizar la coherencia, ya que cada servicio puede actuar de manera independiente.

API Gateway

Un API Gateway es una interfaz que expone una API para la interacción entre los clientes y los servicios en una arquitectura de microservicios. Este componente centraliza el manejo de algunas funciones comunes y necesarias para mantener la integridad y el rendimiento de la arquitectura.

Aquí están algunos de los aspectos clave del API Gateway:

- Punto de entrada único: En una arquitectura de microservicios, un cliente podría necesitar interactuar con múltiples servicios para completar una única operación. En lugar de requerir que el cliente haga solicitudes a cada servicio individualmente, el API Gateway proporciona un punto de entrada único que enruta las solicitudes a los servicios apropiados.

- Manejo de solicitudes: El API Gateway puede manejar tareas relacionadas con las solicitudes, como autenticación, autorización, balanceo de carga, limitación de tasa (throttling) y enrutamiento de solicitudes. Esto permite a los microservicios enfocarse en sus tareas específicas sin preocuparse por estos aspectos.

- Transformación de solicitudes y respuestas: En algunos casos, los datos que entran o salen de los servicios pueden necesitar ser transformados para ser más útiles o coherentes. Por ejemplo, un servicio puede devolver datos en un formato que no es óptimo para el cliente. El API Gateway puede realizar estas transformaciones.

- Descubrimiento de servicios: En una arquitectura de microservicios, los servicios pueden ser desplegados, actualizados y escalados dinámicamente. El API Gateway puede trabajar con un registro de servicios para rastrear la ubicación y el estado de los servicios en el sistema.

- Fallo y latencia: Un API Gateway también puede ayudar a manejar los fallos y la latencia en la arquitectura de microservicios. Por ejemplo, puede implementar patrones de resiliencia como el Circuit Breaker para manejar fallos en los servicios.

En resumen, un API Gateway juega un papel crucial en una arquitectura de microservicios al manejar varias tareas transversales, permitiendo que los servicios se concentren en su lógica de negocio específica. Sin embargo, también es una pieza crítica de infraestructura que debe ser cuidadosamente diseñada y mantenida, ya que cualquier fallo en el API Gateway podría tener un impacto significativo en todo el sistema.

Patrones de Resiliencia

Los patrones de resiliencia son estrategias para ayudar a un sistema a lidiar con fallos y recuperarse de ellos. En una arquitectura de microservicios, estos patrones son particularmente importantes debido a la naturaleza distribuida del sistema. A continuación, se presentan algunos patrones de resiliencia comunes en microservicios.

- Timeouts: este patrón limita el tiempo que un servicio puede esperar una respuesta. Si la respuesta no se recibe dentro del tiempo especificado, la solicitud se considera fallida. Los timeouts son esenciales para evitar que un servicio quede bloqueado al esperar una respuesta de un servicio que está fallando o que está sobrecargado.

- Retries: este patrón implica reintentar automáticamente una solicitud que ha fallado. Esto puede ser útil para manejar errores transitorios, como una red inestable. Sin embargo, los retries deben usarse con cuidado para evitar sobrecargar aún más un servicio que ya está fallando.

- Circuit Breaker: permite a un servicio dejar de hacer solicitudes a otro servicio si se detecta que este último está fallando. Después de un tiempo predefinido, se permite una solicitud de "prueba" para ver si el servicio ha vuelto a estar disponible. Si la solicitud de prueba tiene éxito, el circuito se cierra y las solicitudes pueden continuar; si falla, el circuito se mantiene abierto por otro período de tiempo.

- Bulkheads: implica aislar los fallos en una parte del sistema para evitar que se propaguen a otras partes. Este patrón toma su nombre de los compartimentos estancos (bulkheads) de un barco, que pueden ser sellados para evitar que el agua fluya de un compartimento a otro.

- Backpressure: se utiliza para manejar la sobrecarga. Cuando un servicio no puede manejar más solicitudes, puede usar backpressure para señalar a los clientes o a otros servicios que reduzcan la tasa de solicitudes.

Estos patrones de resiliencia pueden ayudar a mantener la disponibilidad y la confiabilidad de un sistema de microservicios, incluso cuando se producen fallos. Sin embargo, también es importante recordar que los patrones de resiliencia no son una solución a todos los problemas; deben combinarse con otras prácticas, como el monitoreo y el manejo de errores, para crear sistemas verdaderamente resilientes.

Escalabilidad

Uno de los principales beneficios de una arquitectura de microservicios es su escalabilidad. Los microservicios pueden ser escalados individualmente de acuerdo a la demanda, lo que permite a la arquitectura adaptarse a diferentes cargas de trabajo de manera más eficiente y eficaz en comparación con las arquitecturas monolíticas. A continuación, se describen algunos aspectos clave de la escalabilidad en microservicios.

Escalabilidad Horizontal y Vertical

La escalabilidad en la arquitectura de microservicios puede ser horizontal o vertical, y ambas son estrategias fundamentales para manejar las demandas variables de los recursos del sistema. Además, son estrategias complementarias. La elección de cuándo y cómo escalar depende de las características y requisitos específicos de cada servicio.

Escalabilidad Horizontal

La escalabilidad horizontal, también conocida como escalado lateral o escalado out/in, se refiere a la adición o eliminación de instancias de un servicio en respuesta a las fluctuaciones de la carga de trabajo. Esto es particularmente beneficioso en una arquitectura de microservicios, ya que cada servicio puede escalar independientemente de los demás, permitiendo un mayor control y eficiencia.

Por ejemplo, si un servicio de comercio electrónico experimenta un aumento de la demanda durante una venta flash, sólo los servicios relacionados con el manejo de pedidos y pagos podrían necesitar ser escalados horizontalmente para manejar el aumento de tráfico, mientras que otros servicios, como los de revisión de productos, podrían permanecer sin cambios.

El escalado horizontal es efectivo para mejorar la disponibilidad y la tolerancia a fallos, ya que incluso si una instancia falla, las demás instancias del mismo servicio pueden seguir manejando las solicitudes. Sin embargo, también puede introducir complejidad en el manejo de datos y estado, en la sincronización entre instancias y en la necesidad de balanceo de carga efectivo.

Escalabilidad Vertical

La escalabilidad vertical, también conocida como escalado up/down, se refiere a aumentar o disminuir los recursos asignados a una instancia de un servicio, como la memoria, el CPU o el almacenamiento. Esto puede ser útil para manejar cargas de trabajo que son intensivas en términos de recursos, pero que no se benefician de la ejecución paralela en múltiples instancias.

Por ejemplo, un servicio de análisis de datos podría necesitar ser escalado verticalmente para procesar grandes conjuntos de datos de manera eficiente. Sin embargo, el escalado vertical tiene limitaciones físicas y puede ser costoso, ya que implica añadir hardware más potente o adquirir instancias más grandes en una plataforma en la nube. Además, no mejora la disponibilidad ni la tolerancia a fallos de la misma manera que el escalado horizontal.

Autoscaling

El autoscaling, o escalado automático, es una característica esencial para mantener la eficiencia y el rendimiento en una arquitectura de microservicios. Esta capacidad permite que el sistema ajuste automáticamente el número de instancias de un servicio o su potencia de acuerdo con las demandas actuales de la carga de trabajo.

El autoscaling generalmente se basa en métricas en tiempo real, como el uso de la CPU, la memoria, el número de solicitudes por segundo, o incluso métricas de negocio, para determinar cuándo y cómo escalar. Por ejemplo, si el uso de la CPU de un servicio excede un umbral predefinido, el sistema podría iniciar automáticamente nuevas instancias de ese servicio para manejar la carga adicional.

Hay dos formas principales de autoscaling: el escalado horizontal automático y el escalado vertical automático. El escalado horizontal automático ajusta el número de instancias de un servicio, mientras que el escalado vertical automático ajusta los recursos asignados a una instancia, como la CPU y la memoria.

El autoscaling tiene varios beneficios:

- Eficiencia de recursos: El autoscaling puede ayudar a utilizar los recursos de manera más eficiente, al permitir que el sistema se adapte a las demandas de la carga de trabajo en tiempo real.

- Mejora del rendimiento: Al ajustar el número de instancias o los recursos asignados a un servicio, el autoscaling puede ayudar a mantener el rendimiento del sistema incluso durante picos de carga.

- Ahorro de costos: En entornos en la nube, el autoscaling puede reducir los costos al asegurar que sólo se utilicen y se paguen los recursos necesarios.

- Resiliencia: El autoscaling puede mejorar la resiliencia del sistema, al permitir que el sistema maneje los fallos y las interrupciones de manera más efectiva.

Sin embargo, implementar el autoscaling puede ser un desafío, ya que requiere un entendimiento profundo de las características de la carga de trabajo y de las capacidades del sistema. También es importante tener en cuenta que el autoscaling puede no ser la solución adecuada para todas las situaciones y puede ser más efectivo cuando se combina con otras técnicas de gestión de la carga y de los recursos.

Balanceo de Carga

El balanceo de carga es una estrategia esencial en una arquitectura de microservicios para distribuir las solicitudes de red de manera eficiente a través de un conjunto de servidores o instancias de servicio, maximizando así el rendimiento y minimizando el tiempo de respuesta. En un contexto de microservicios, el balanceo de carga es crucial para la escalabilidad y la disponibilidad de los servicios.

Aquí hay algunos puntos clave sobre el balanceo de carga en microservicios:

- Distribución de solicitudes: Un balanceador de carga acepta las solicitudes entrantes y las distribuye entre varias instancias de servicio, asegurándose de que ninguna instancia se sobrecargue. Esto puede hacerse utilizando una variedad de algoritmos, como round robin, donde las solicitudes se distribuyen secuencialmente a cada servidor en orden, o least connections, donde las solicitudes se envían al servidor con el menor número de conexiones activas.

- Alta disponibilidad y tolerancia a fallos: Al distribuir las solicitudes entre múltiples instancias, el balanceo de carga ayuda a garantizar que si una instancia falla, las solicitudes pueden ser redirigidas a otras instancias activas. Esto es crucial para mantener la disponibilidad y la fiabilidad de los servicios en una arquitectura de microservicios.

- Escalabilidad: El balanceo de carga es fundamental para apoyar la escalabilidad horizontal en microservicios. A medida que se añaden más instancias de un servicio para manejar una mayor carga de trabajo, el balanceador de carga puede distribuir las solicitudes de manera eficaz entre todas las instancias disponibles.

- Descubrimiento de servicios: En muchos casos, los balanceadores de carga también trabajan junto con los sistemas de descubrimiento de servicios, que mantienen un registro de las instancias de servicio disponibles. Esto permite al balanceador de carga conocer la ubicación y el estado de cada instancia de servicio.

Es importante señalar que el balanceo de carga puede introducir sus propios desafíos, como la necesidad de mantener la coherencia de los datos entre las instancias y manejar la "afinidad de la sesión" para las solicitudes que deben ser manejadas por la misma instancia. Además, el balanceador de carga en sí puede convertirse en un punto de fallo si no se implementa con alta disponibilidad.

Diseño Sin Estado

El diseño sin estado es un principio fundamental en la arquitectura de microservicios. En un servicio sin estado, cada solicitud es independiente y no depende de ninguna información previa o futura. Esto significa que el servicio no necesita recordar información de la solicitud anterior para procesar la siguiente.

El diseño sin estado tiene varios beneficios en la arquitectura de microservicios:

- Escalabilidad: Los servicios sin estado son más fáciles de escalar horizontalmente, ya que cualquier instancia de un servicio puede manejar cualquier solicitud. No necesitan compartir ni sincronizar el estado, lo que hace que la adición de nuevas instancias sea un proceso directo.

- Resiliencia: Los servicios sin estado son más resistentes a los fallos, ya que no hay estado que se pueda perder si una instancia falla. Si una instancia se cae, otra puede asumir fácilmente su carga de trabajo.

- Simplicidad: Los servicios sin estado son más simples de entender y mantener. No tienen que manejar la complejidad de la sincronización del estado o el manejo de las condiciones de carrera.

No obstante, hay situaciones en las que mantener algún estado puede ser inevitable, como en el caso de las sesiones de usuario o las transacciones de varias etapas. En estos casos, se puede utilizar una variedad de estrategias para manejar el estado, como el almacenamiento de estado en una base de datos o el uso de un servidor de sesiones. Sin embargo, estas soluciones pueden introducir su propia complejidad y desafíos, y deben ser manejadas con cuidado.

Desarrollo y ciclo de vida

El ciclo de vida de desarrollo de microservicios es significativamente diferente del de las aplicaciones monolíticas, y puede ser un desafío para las organizaciones que están acostumbradas a los enfoques tradicionales de desarrollo de software.

- Desarrollo Independiente: Uno de los principales beneficios de la arquitectura de microservicios es que cada servicio puede ser desarrollado, desplegado y escalado de manera independiente. Esto permite a los equipos de desarrollo trabajar en diferentes servicios simultáneamente sin interferir entre sí. También significa que cada servicio puede ser desarrollado utilizando las tecnologías y herramientas que mejor se adapten a su propósito específico.

- Integración Continua y Entrega Continua (CI/CD): La integración continua y la entrega continua (CI/CD) son prácticas esenciales en el desarrollo de microservicios. La CI/CD permite a los equipos de desarrollo integrar y desplegar cambios de manera rápida y confiable, lo que es especialmente importante en un entorno de microservicios donde hay muchos servicios independientes que deben coordinarse entre sí.

- Pruebas: Las pruebas en una arquitectura de microservicios pueden ser un desafío debido a la cantidad de servicios independientes y las interacciones entre ellos. Es importante tener un enfoque de pruebas sólido que incluya pruebas unitarias, pruebas de integración y pruebas de contrato para garantizar que todos los servicios funcionen correctamente tanto individualmente como en conjunto.

- Despliegue: El despliegue de microservicios generalmente implica la creación de contenedores para cada servicio, que luego se despliegan en un entorno de ejecución de contenedores. Esto puede complicarse rápidamente a medida que el número de servicios aumenta, por lo que es esencial tener una buena infraestructura y herramientas de gestión de contenedores.

- Monitoreo y Registro: El monitoreo y registro es crítico en un entorno de microservicios debido a la gran cantidad de servicios y las interacciones entre ellos. Es importante tener una buena visibilidad de la salud y el rendimiento de cada servicio, así como de las interacciones entre servicios.

- Mantenimiento y Evolución: A diferencia de una aplicación monolítica, donde la evolución de la aplicación puede requerir cambios en todo el código base, en una arquitectura de microservicios, cada servicio puede evolucionar de forma independiente. Esto puede permitir una mayor velocidad de innovación, pero también puede llevar a desafíos de coordinación y consistencia.

El ciclo de vida de desarrollo de los microservicios tiene sus propios desafíos y complejidades, pero también ofrece muchas oportunidades para una mayor agilidad y velocidad de desarrollo. Es esencial tener un buen entendimiento de estos aspectos y adoptar las prácticas y herramientas adecuadas para manejarlos de manera efectiva.

Casos de uso

Los microservicios son particularmente útiles en ciertos casos de uso, especialmente cuando la escalabilidad, la velocidad de desarrollo y la adaptabilidad son factores clave. A continuación se presentan algunos casos de uso típicos:

- Aplicaciones a gran escala: las aplicaciones a gran escala que requieren alta disponibilidad, fiabilidad y escalabilidad pueden beneficiarse enormemente de la arquitectura de microservicios. En lugar de construir una gran aplicación monolítica que puede ser difícil de escalar y mantener, los desarrolladores pueden construir muchas pequeñas aplicaciones de microservicios que pueden ser escaladas, desplegadas y mantenidas de manera independiente.

- Organizaciones con varios equipos de desarrollo: Las organizaciones con varios equipos de desarrollo pueden encontrar que la arquitectura de microservicios les ayuda a trabajar de manera más eficiente. Cada equipo puede centrarse en un servicio específico, utilizando las tecnologías y herramientas que mejor se adapten a sus necesidades.

- Aplicaciones que necesitan ser altamente resilientes: La arquitectura de microservicios puede proporcionar una alta resiliencia, ya que un fallo en un servicio no debería afectar al funcionamiento de los demás. Esto puede ser especialmente útil para las aplicaciones que no pueden permitirse ningún tiempo de inactividad.

- Aplicaciones que requieren una rápida puesta en el mercado: Los microservicios pueden acelerar el tiempo de lanzamiento al mercado al permitir que los equipos de desarrollo trabajen en paralelo en diferentes servicios. También pueden facilitar la iteración rápida, ya que los cambios pueden ser desplegados en un servicio específico sin afectar a los demás.

- Modernización de aplicaciones existentes: La arquitectura de microservicios puede ser útil para las organizaciones que están tratando de modernizar las aplicaciones existentes. En lugar de reescribir toda la aplicación desde cero, pueden descomponer la aplicación existente en microservicios que pueden ser modernizados de manera independiente.

A pesar de estos beneficios, es importante señalar que los microservicios no son la solución adecuada para todos los casos de uso. Las aplicaciones más pequeñas o menos complejas pueden no beneficiarse de la arquitectura de microservicios, y pueden encontrar que un enfoque monolítico o de servidor único es más adecuado. Asimismo, los microservicios pueden añadir una complejidad significativa y requerir una inversión considerable en términos de infraestructura y habilidades de desarrollo. Por lo tanto, es crucial considerar cuidadosamente las necesidades y capacidades específicas de la organización antes de adoptar la arquitectura de microservicios.